AIの進化を支える深層学習は、スマートフォンの顔認証システムやネット検索のおすすめ表示、CADの自動設計機能など、身近なサービスの裏側でその力を発揮しています。

しかし、「どういう原理で動いているのか?」と聞かれると、いまいちピンとこない方もいるのではないでしょうか。

この記事では、深層学習の基本をわかりやすく解説します。ChatGPTとの関係性や、混同されやすい機械学習との違いもお伝えするので、この機会にAI時代の核となる深層学習への理解を深めておきましょう。

深層学習とは?

深層学習は、人の脳の仕組みを模倣したコンピューターの学習方法です。英語表記は「Deep Learning(ディープラーニング)」で、画像認識や音声認識、自然言語処理などで人間以上の成果を上げる場面も増えています。

深層学習は、人の脳の仕組みを模倣したコンピューターの学習方法です。英語表記は「Deep Learning(ディープラーニング)」で、画像認識や音声認識、自然言語処理などで人間以上の成果を上げる場面も増えています。

2016年、囲碁AI「AlphaGo(アルファ碁)」が世界トップクラスの棋士に勝利したニュースは、深層学習の能力が人間を超えることを示した代表例です。

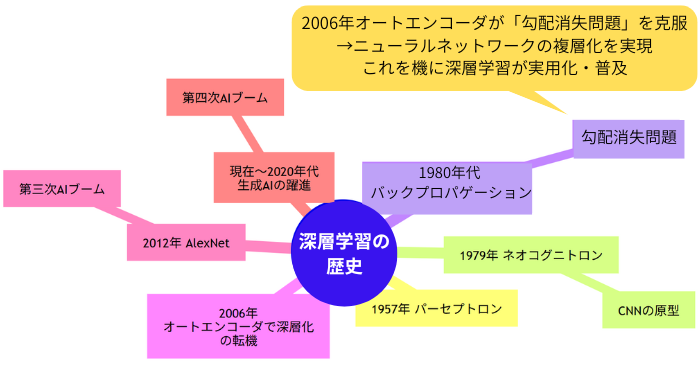

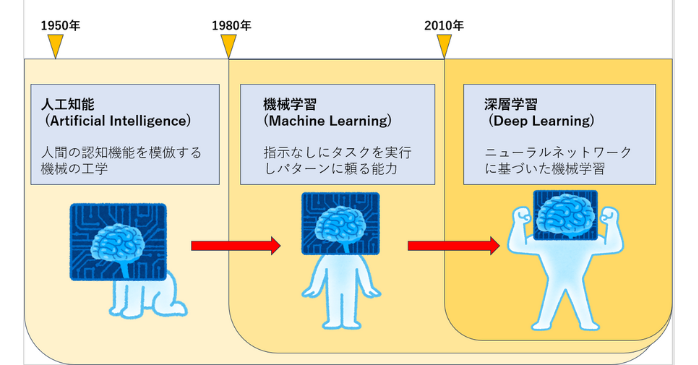

深層学習の歴史

深層学習の歴史は、1957年に登場したシンプルなコンピューターモデル「パーセプトロン」から始まりました。

1979年には、日本の福島邦彦氏が画像認識AIの基礎「CNN(畳み込みニューラルネットワーク)」の原型「ネオコグニトロン」を提案。しかし、当時のコンピューター性能では実用化は困難でした。

停滞の時代

1980年代に入ると、「バックプロパゲーション」というアルゴリズムが登場し、3層ネットワークの学習が可能になりました。しかし、4層以上の深いネットワークでは「勾配消失問題」が生じ、長い間、研究は停滞します。

「オートエンコーダ」の登場

転機が訪れたのは、「オートエンコーダ」が登場した2006年のことです。オートエンコーダは、データの圧縮と復元を繰り返す、深い層での効率的な学習手法で、この技術が深層学習の本格的な実用化への道を開きました。

現在では、より効率的な学習手法が登場したため、オートエンコーダが直接使われる機会は減りましたが、深層学習の歴史において極めて重要な役割を果たしたことは間違いありません。

AIブームの到来

そして2012年、「AlexNet」という深層学習モデルが、画像認識のコンテストで圧倒的な成果を収めます。これをきっかけに第三次AIブームが到来しました。現在では、生成AIの飛躍的な進化を受け、ついに第四次AIブームの幕が開き始めています。

AIの進化により、まるで本物のような動画や音声を作成できるDeep Fakeも登場しました。Deep Fakeはもともとエンターテインメントや芸術作品を作るための技術ですが、近年は偽情報の拡散やプライバシー侵害など課題点も指摘されはじめています。

生成AIセミナーでは、生成AIの基礎から具体的な活用法、そしてプロンプトエンジニアリングといった実践的なテクニックまで、幅広く学べます。AIの便利さと危険性の両方を理解し、責任を持って向き合う姿勢を身につけましょう。

Deep Fakeの危険性については、以下の記事で詳しく解説しています。

深層学習の仕組み

深層学習は「ニューラルネットワーク」という仕組みを基盤にしています。ここでは、このニューラルネットワークの仕組みを、以下の4点から見ていきましょう。

- ニューラルネットワークの3つの層

- ニューロンが働く仕組み

- 多層構造の意味

- 深層学習のネットワークモデル

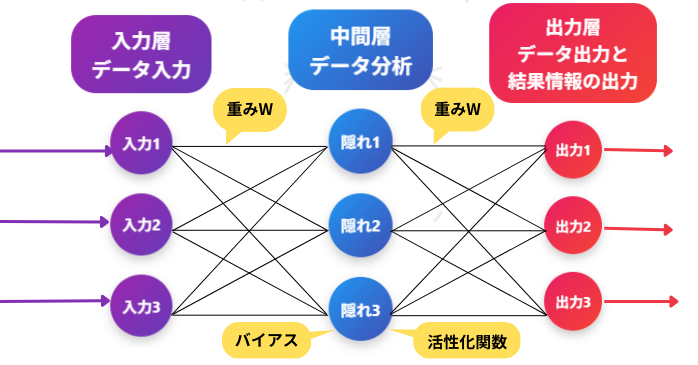

①ニューラルネットワークの3つの層

ニューラルネットワークは、次の3つの層からできています。

入力層

データが最初に入る場所です。例えば、画像なら「ピクセル情報」が、音声なら「音の波形」が入力されます。

中間層(隠れ層)

入力を処理し、特徴を取り出す層です。線や輪郭、音の周波数など、段階的に情報を学びます。

出力層

最終的な答えを出す層です。画像から「猫」や「犬」を、音声から「こんにちは」といった言葉を識別して出力します。

この3つの層は、それぞれ「ニューロン」が情報をやりとりすることで成り立っています。

②ニューロンが働く仕組み

この3つの層は、それぞれが無数のニューロンで構成されています。上記画像の「〇」がニューロンを示しており、個々のニューロンは、以下の要素で次のニューロンに情報を伝達します。

重み(Weight)

ニューロン間の「つながりの強さ」を示す値です。どの情報が重要かを判断するフィルターのような役割を果たします。学習が進むにつれて、この重みの値が自動的に調整され、AIの精度が向上します。

バイアス(Bias)

ニューロンが情報を次へ伝えやすくする度合いを調整する値です。これがあることで、ニューロンが活動を開始する「しきい値」が変わり、学習の柔軟性が高まります。

活性化関数(Activation Function)

ニューロンが受け取った情報が、次のニューロンに送られるかどうかを決定するフィルターです。これにより、複雑な非線形(直線表現できないグラフ)問題を解けるようになります。

なお、かつては「シグモイド関数」が主流でしたが、現在では計算効率の高い「ReLU(正規化線形関数)」などが広く使われています。

③多層構造の意味

この層が少ないと単純な特徴しか捉えられませんが、層を何重にも重ねることで、AIは複雑なパターンを段階的に理解できるようになります。

- 第1層:線や点などシンプルな特徴

- 第2層:輪郭や形など少し複雑な特徴

- 出力層:それらを組み合わせて「猫」「犬」「こんにちは」などを認識

つまり、ニューロンが働く仕組みと多層構造が組み合わさることで、深層学習の高度な理解を実現しているのです。

深層学習のネットワークモデル

深層学習は、目的に応じていくつもの「ネットワークモデル(学習の設計図)」があり、それぞれに得意分野があります。ここでは、代表的なものを3つ紹介しましょう。

- 畳み込みニューラルネットワーク(CNN)

- トランスフォーマー(Transformer)

- 敵対的生成ネットワーク(GAN)

①畳み込みニューラルネットワーク(CNN)

これは、主に画像認識で活躍するモデルです。人間の目や脳が物を認識する仕組みをまねて、画像の特徴を段階的に抽出します。すべての層がつながっているわけではなく、必要な部分だけを効率的に結合する仕組みを持つため、従来型より速く学習できます。

例えば、最初の層で線や角を検出し、次の層で目や耳などのパーツを見つけ、最終的に「猫」と判断する流れです。

②トランスフォーマー(Transformer)

こちらは、文章や言語を扱うのが得意なモデルです。「自己注意機構」と呼ばれる仕組みで、文章の中の単語同士の関係を自動で見つけ出します。これにより、従来のRNN(順番通りに処理する方式)よりも効率的に、しかも並列で学習ができるようになりました。

例えば、「彼はリンゴを食べた」という文では、「彼」と「食べた」が強く結びついていることを理解できます。

③敵対的生成ネットワーク(GAN)

こちらは、「生成器」と「判別器」という2つのAIを競わせるユニークな仕組みです。生成器は偽物を作り出し、判別器はそれを見破ろうとします。このやり取りを繰り返すことで、まるで本物のような画像や音声を作れるようになります。

例えば、最初は粗い顔画像しか作れなくても、判別器に鍛えられることで徐々に本物そっくりの顔を生成できるようになります。

ニューラルネットワークについては以下の記事でも詳しく解説しているので、ぜひこちらも参照しながら理解を深めてください。

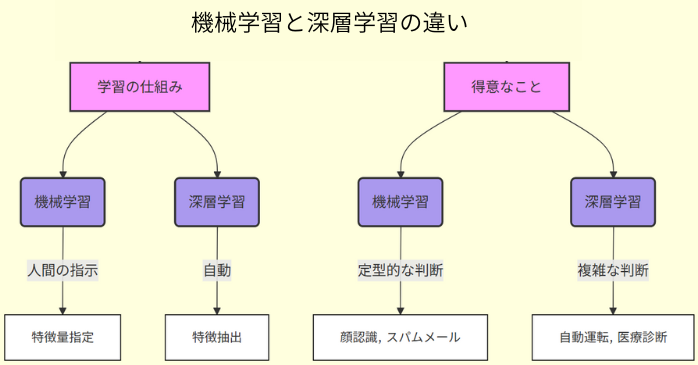

深層学習と機械学習の違い

AIを支える技術には大きく「機械学習」と「深層学習」があります。両者はしばしば混同されるため、ここで分かりやすく解説しましょう。

- 機械学習と深層学習の違いは「学習の仕組み」

- 機械学習の手法

①機械学習と深層学習の違いは「学習の仕組み」

機械学習と深層学習は、どちらもデータからパターン抽出しますが、その仕組みに大きな違いがあります。

機械学習では、人間があらかじめ「特徴量(データの判別に使う目印)」を指定して学習を進めます。例えば「猫の画像=尖った耳の形や長いヒゲ」のようにそれぞれの特徴を人間が教えなくてはいけません。

一方、深層学習は多層のニューラルネットワークを使い、コンピューターが自動的に重要な特徴を見つけ出します。つまり、人間が細かく指示を出さなくても、システムが自律的に学習を深めていくのです。

そのため、機械学習は顔認識やスパムメール検知のような定型的な処理を得意としていますが、深層学習は自動運転や医療診断といった複雑な判断が求められる分野で力を発揮します。

②機械学習の手法

機械学習には大きく3つの学習手法があります。以下の表に特徴を整理しました。

| 手法 | 特徴 | 具体例 |

| 教師あり学習 | 入力と正解データをセットで学習し、未知のデータを予測 | 画像認識、株価予測 |

| 教師なし学習 | 正解のないデータをもとに、隠れた構造やパターンを発見 | クラスタリング、購買データ分析 |

| 強化学習 | 試行錯誤を通じて報酬を最大化する行動を学習 | ゲームAI、ロボット制御 |

教師あり学習は、答えのある問題を解く力があり、教師なし学習はデータの整理が得意です。強化学習は経験から学ぶため、自律的に最適な行動を選択できます。

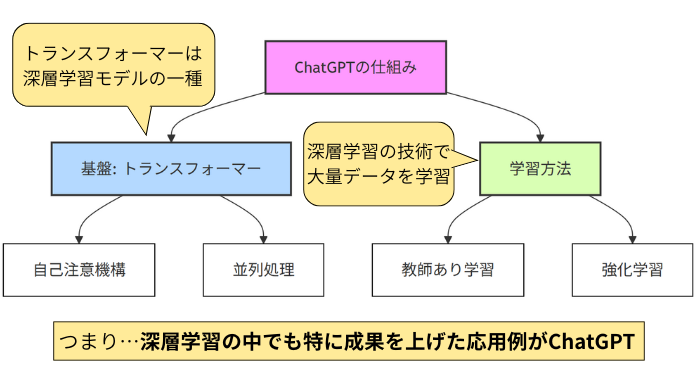

深層学習とChatGPTの関係

ChatGPTは、深層学習の中でも特に成果を上げた応用例のひとつで、基盤には2017年に登場したトランスフォーマー(Transformer)というモデルがあります。

- ChatGPTの要・トランスフォーマーモデル

- 2段階の学習方法

ChatGPTの要・トランスフォーマーモデル

トランスフォーマーは、文章中の重要な単語に注目して理解する「自己注意機構」を備え、長い文章でも前後の文脈を正確に捉え、意味の通った回答を生み出せます。

従来のRNN(リカレントニューラルネットワーク)のように順番通り処理する手法とは異なり、複数の計算を同時に進められるため、大量のテキストも効率よく吸収できます。

2段階の学習方法

ChatGPTの学習は、以下の2段階です。

- 教師あり学習で膨大なテキストから言語パターンを習得

- 強化学習でユーザーのフィードバックを参考に応答の精度を向上

この段階的かつ繰り返しの学習方法により、私たちが自然だと感じる会話を実現しています。

トランスフォーマーは言語処理だけでなく、最近では脳波解析などの分野でも従来手法を上回る精度を示しており、深層学習の可能性の広さを改めて示しています。

深層学習の利用事例と課題点

深層学習により、私たちの生活は目に見えて便利になっています。ここでは、深層学習の利用事例、およびそこから浮き彫りになった課題点を解説しましょう。

- 日常生活での活用

- 社会を豊かにする深層学習の活用

- 深層学習の危険性

- 世界的な重要性と私たちの向き合い方

①日常生活での活用

まずは、日常生活における深層学習の活用を見てみましょう。

スマートフォンの音声認識が格段に正確になり、写真に写った人物や物体を瞬時に見分けられるようになったのは、その代表的な成果です。

こうした便利さが身近に浸透する一方で、世界中を驚かせるような大きな成果もありました。その一つが、GoogleのAlphaGoが囲碁の世界最強棋士に勝利した出来事です。「あと10年は不可能」と言われていた予想を覆し、人工知能の可能性を広く知らしめました。

②社会を豊かにする深層学習の活用

医療の現場でも深層学習は力を発揮しています。病気の早期発見や診断支援に活用され、命を救う一助を担っています。さらに、自動運転車の安全性向上にも貢献し、私たちの移動方法は大きく様変わりしました。

ものづくりの現場で必須のCAD(コンピューター支援設計)でも深層学習の活用が進んでいます。例えば、複雑な設計の自動化、膨大な設計データから必要な情報への迅速なアクセスも、この深層学習によるものです。

③深層学習の危険性

しかし、光があれば影もあります。中国では市民監視システムに活用され、プライバシーの問題が深刻化。また、ディープフェイク技術によって本物そっくりの偽動画が作られ、著名人の名誉を傷つける事件も後を絶ちません。

深層学習は現代の生成AIの基盤技術であり、AI進化の原動力でもありますが、「便利さと危険性が表裏一体」であることも如実に示しています。

④世界的な重要性と私たちの向き合い方

深層学習は国家の競争力を左右するほど重要な技術で、世界中の国々がしのぎを削って研究開発を進めています。だからこそ、私たちは便利さの恩恵を受けつつ、その危険性にも目を向け、責任をもって付き合わなくてはいけません。

生成AIセミナーでは、現代の生成AIの最新技術を学び、同時に抱えている課題点への理解を深めるカリキュラムをご用意しております。お得&効率的に学べるスケジュールは、以下のページでご確認いただけます。

セミナー名 生成AIセミナー 運営元 GETT Proskill(ゲット プロスキル) 価格(税込) 29,700円〜 開催期間 2日間 受講形式 対面(東京・名古屋・大阪)・ライブウェビナー・eラーニング

深層学習についてまとめ

深層学習の可能性は無限大ですが、同時に課題も抱えています。それを知ることが、今を生きる私たちに最も求められている姿勢なのです。深層学習は未来を築く重要な技術であるからこそ、社会全体でその恩恵とリスクへの理解を深めていきましょう。